토모큐브

의학 드라마는 방송가에서 새롭지 않더라도 끊임없이 소환되는 단골 소재 중 하나이다. 그만큼 흥행이 보증된 흥행 보증 수표로써 대중의 관심을 붙잡는다. 삶과 죽음을 가르는 생명의 최전선에서 의료진의 고군분투로 극적 긴장감을 불어넣어 한국뿐 아니라 많은 나라의 단골 소재이다. 그러나 현실에서 의료계에 계신 분들과 만나보면 많은 분들이 너무 현실성이 없어서 차마 볼 수가 없다고 하신다. 그 말을 듣고 다시 생각해보니, 많은 의학 드라마들은 그냥 병원에서 연애하는 드라마이거나 모든 걸 다 헌신하는 한 명의 천재의사가 모든것을 해결하는 무협지 같은 드라마였다. 현실에서 실제 사람을 살리고 계신 분들에게 시절 좋게 연애나 하고 뭐든지 해결하는 무공과 같은 의술을 펼치는 드라마가 다시없을 코미디일듯하다. 그런데 최근 들어 의료계에 많이 적용되고 이슈가 되고 있는 AI 기술들이 언론을 통해 공개되는 장면을 보고 있자면 그런 의학 드라마 같은 면이 많다. 이 글에서는 몇 연구가 언론에 소개되어 전달되는 모습을 통해 의료 AI의 발전과 함께 문제점을 짚어보고자 한다.

아무리 이쁜 기술을 멋진 회사에서 만들었어도 현실을 무시했으면 그냥 이쁜 쓰레기이다.

딥러닝 (Deep learning)이라고 불리는 기계학습의 한 방법론이 크게 이슈가 되어 영상 인식, 자연어 처리 등 여러 분야에서 엄청난 성능 향상을 불러왔다. 의료계에서는 다른 분야에서의 성공보다는 당뇨성 망막 병증을 안저 영상으로 진단하여 안과의만큼의 성능을 보여 IT 기업인 구글의 논문이 의료계에 저명한 저널인 JAMA에 실린 사건이 AI라 불리는 기술을 달리 보게 된 계기가 되었다 [1]. 그런 구글의 의료 연구팀이 이후 망막 스캔 영상을 통한 심장질환 발병 가능성을 예측하는 연구를 Nature Biomedical Engineering 지에 발표한다 [2]. 많은 신문 기사와 블로그에서는 이 연구를 두고 "망막 스캔으로 심장질환 발병 가능성을 진단하는 AI 기술"로 표현하고 심장내과 임상에서 기존에 쓰이는 방법을 대체할 수 있고 간단히 더 좋은 성능을 낼 수 있다고 보도했다 [3].

그러나 이 논문에서 예측하려고 하는 당뇨(HbA1C), 고혈압, 고지혈증, 고령, 남성, 비만(BMI), 흡연 등은 논문에서 최종적으로 예측하려고 하는 major advere cardiovasc event (MACE)의 predisposing risk factor이다. 이들 위험인자들이 오랜 기간 지속되면 동맥경화로 macro- and microvascular complication을 일으키고 최종 진행 단계에서, 결국 target organ failure (TOF)가 발생하는데, MACE는 심장혈관의 TOF이다. 그러므로 논문의 내용은 TOF에 해당하는 안저소견으로 predisposing factor를 예측하는 것은 '결과'로 '원인'을 예측하는 격이 된다. 당연히 관계는 있으므로 유의한 상관관계는 얻을 수 있겠지만, 인과관계가 뒤집힐 수 있어 해석상의 오류 가능성이 높다. 그리고 예측하는 risk factor 여부는 환자에게 질문하면 얻을 수 있는 것들이 대부분이다. 한마디로 안저검사까지 할 필요는 없다.

또한 많은 기사 그리고 구글 홍보 행사에서는 기존 병원에서 진행하는 혈액검사만큼 좋다고 광고하는데, 논문 결과로 보면 혈압, BMI, 성별, 나이, 흡연 여부만 넣어도 72%의 정확도를 확보한다고 나와있고 제안된 안저 영상 분석까지 더하면 1% 나아진 73%의 정확도를 나타낸다. 참조 논문이나 다른 임상 논문을 다시 혈액이나 기본적인 검사만으로도 80% 이상을 이미 보이고 있다. 물론 MACE를 예측하기 위해 가기 전단계의 과정으로 학습했다고 하더라도 인과관계가 뒤집힐 수 있는 상황이니 이건 무리수다.

또한, 결과에서 당뇨 여부와 상관없이 결과가 안정적으로 나온다고 주장하였는데, MACE의 매우 중요한 위험인자 당뇨 유병 기간, 공복 혈당, 혈당조절 상태(HbA1C) 등 당뇨에 관한 변수가 완전히 빠져 있다. 또한 데이터베이스 구성에서 보면 전체 환자의 55% 정도만이 HbA1c 정보를 갖고 있었고, 심지어 '환자 말'만 듣고 당뇨 진단 내린 경우들도 있다. 또한 당뇨와 관계없다고 하지만, 학습 데이터 대부분이 당뇨환자인 데이터베이스가 주이므로 코호트가 바이 어스되었고, 전체 환자의 16%만이 이 연구의 primary endpoint인 MACE 정보를 갖고 있었다. 결국 MACE 모델링에는 정답을 가진 16%의 환자만 포함된 제한적인 환경에서 이루어졌다. 또한 이 연구에서는 당뇨 변수 정의나 진단 자체를 신뢰하기 어려운 데이터를 사용하고 당뇨와의 관계가 없다고 주장하고 있다. 신빙성 없고 일관성을 확인할 수 없는 데이터를 썼으니 당연히 그 요인이 나타나지 않은 것으로 보는 것이 관계가 없다고 하는 것보다는 합리적인 주장일 것이다. 아마 구글에서 진행된 연구이니 엄청난 자금이 투입되었을 거고, 기존 문진과 간단한 검사보다 1% 나아진 결과이지만 그럼에도 불구하고 유명 저널에 나왔고, 그리고 여기저기서 의료 혁신을 이루었다고 광고하니 만약 어느 스타트업에서 했으면 투자 받기 딱 좋은 연구이다. 그러나 연구도 이쁘고, 기술도 이쁘나, 제대로 된 현실과 임상 프로세스를 반영하지 못했다면 쓸데가 없는 이쁜 쓰레기일 뿐이다.

무협지 무공 비서처럼 AI 혼자서 혁신을 가지고 오지는 않는다.

최근 미시건 대학교에서는 Stimulated Raman Histology (SRH)라는 기술로 생성된 영상에 딥러닝 기술을 적용하여 빠르게 수술 중 뇌종양 병리 진단을 할 수 있는 연구를 Nature Medicine에 개제하였다 [4]. 이 연구에 관련하여 국내 신문 기사에 제목은 “닥터 AI, 뇌종양 진단도 전문의 뛰어넘었다”이고, “AI, 150초 만에 뇌종양 진단”이라고 홍보했다[5]. AI가 적용되니 갑자기 진단 정확도도 전문의를 뛰어넘었고, 그 진단 시간도 엄청나게 단축되었다고 기사에 실려있다. 그러나 이 논문을 이렇게 이해하면 안 된다. 왜 수술 중 병리 진단이 왜 빨라야 하고 왜 지금 오래 걸리는지를 이해해야 한다.

수술 중 병변의 병리 진단을 요청하면 그것을 병리과 전문의들이 볼 수 있는 영상으로 얻기 위해서는 굳히고 얇게 썰고 염색하는 과정이 필요하다. 그러나 이 과정을 수술 과정 중에 빨리해야 하기에 빨리 굳히기 위해서 얼리고, 썰어서 염색한다. 분석 프로그램으로 적용된 AI를 적용한다고 이 과정이 빨라지지는 않는다. 이 논문의 저자들인 미시건 대학의 Sandra Camelo-Piragua와 Daniel A. Orringer 교수는 Stimulated Raman Scattering Microscopy로 가상적인 조직 염색 영상을 만드는 연구를 진행했던 분들이다 [6]. 그러니깐 분자의 진동 정도 같은 걸 측정할 수 있는 레이저 장비를 써서 새로운 모달리티 영상을 만들고, 그 영상을 기반으로 H&E 영상과 같은 가상의 병리조직 염색 영상을 생성하는 연구를 진행했었다. 이를 통해 염색 과정 없이 병리조직 영상을 얻을 수 있어서 진단 시간이 줄어든 것이다. 단순히 갑자기 AI를 적용했다고 기존 임상 프로세스가 비약적으로 빨라지거나 영상이 빨리 생성되지는 않았다. 또한 이 연구에서는 Control group인 병리과 전문의 분들은 frozen H&E 염색 영상을 보고 진단하고, AI는 생성된 SRH 영상을 보고 판단했다. 그리고 양쪽 그룹에서 틀린 부분이 다르므로 AI와 병리학자가 보완적인 판단하고 이를 합치면 100%에 가까운 정확도를 확보할 수 있다고 주장하고 있다.

그러나 AI와 병리 전문의가 보완적인 판단을 했다기보다는 서로 다른 모달리티가 보완적인 정보를 제공했다고 보는 게 맞다. AI가 병리 전문의의 데이터에서 배우지못한 부분을 맞추고 잘 가르친 영역을 계속 틀린다면 그 AI의 신뢰성이 오히려 의심받아야 한다. 이렇듯 단순히 AI 기술 혼자서 의료계의 오래된 문제를 해결하진 않는다. 새로운 영상 모달리티가 개발된 후에는 새로운 기술이 아직 의료계의 교육시스템에 못 들어갔기에 H&E 영상과 같이 의료게에서 이미 익숙한 모달리티와의 상관관계를 제공하고, 이를 기반으로 AI 기술이 적용되어야 한다. 그리고 또 의료계에 들어가기 위해서는 의료계에서 인정된 임상 검증 절차에 따라 검증되어야 한다. 우리나라에도 세계적으로 선도적인 새로운 모달리티가 개발되고 있다. 일례로 토모큐브라는 회사에서는 SRH와 같이 염색 없이 조직 및 세포의 3차원 구조를 실시간으로 관찰할 수 있는 기술을 개발하여 적용하고 있다 [7]. 이러한 기술이 AI뿐 아니라 제대로 된 의료 문제와 만나야 한다. 그리고 임상에서 제대로 검증받아야 한다. AI는 무협지에 나오는 무공 비서가 아니라 문제 해결을 위한 하나의 도구일 뿐이다.

AI를 의료에 적용하려면 AI와 같은 모호한 단어들을 없애야 한다.

최근 Nature Communications에는 일본에서 진행된 전립선암 관련 병리 영상 연구가 "Automated acquisition of explainable knowledge from unannotated histopathology images"이라는 제목의 논문으로 개제되었다 [8]. 이 연구는 단순히 전립선암 판단 기준으로 사용되는 Gleason score(GS)과 비교하여 환자가 1년 후 혹은 5년 후 재발할 확률을 높은 성능으로 예측할 수 있는 딥러닝 모델을 개발했다는 내용이다. 또한 스스로 이런 과정에서 설명 가능한 지식을 정답이 표기되지 않은 병리영상을 통해 얻을 수 있다고 주장하고 있다. 이런 연구를 언론에서는 “AI 스스로 암 특징 발견”이라는 제목으로 세계 통용 암 진단 기준 외 새로운 병변도 발견한다고 기술한다고 적고 있다 [9]. "unannotated"란 단어에만 집중하면 이 과정을 전체적으로 "스스로"란 단어에 묻혀서 자동으로 진단한다거나 모든 과정이 스스로 된다고 오해할 수 있게 적었다. 이 부분은 딥러닝이 나오기 전에 기계학습 분야에서는 특징 추출과 분류로 나뉘는 과정에서 보자면, 어떤 특징인지 디자인하거나 알려주는 과정이 있었는데, 그 과정을 딥러닝, 아니 정확히는 딥러닝 기반의 auto-encoder와 clustering으로 자동적으로 학습하게 한다는 것이다. 물론 그 특징 추출 이후 판단으로 넘어가는 과정에서는 지도학습 과정이다. 이는 병원에서 정성 들여 만든 1년 후에 재발 그룹과 아닌 그룹으로 나누어 데이터를 기반으로 하고 있기 때문이다. 이 논문을 읽을 때 비교하면서 읽으면 좋은 논문은 "Predicting non-small cell lung cancer prognosis by fully automated microscopic pathology image features" [10]일거 같다. 이 논문은 병리 영상을 보고 폐암 환자의 예후를 예측하는 논문으로 비슷한 목적성을 갖는다. 차이는 이 논문은 그동안 알려진 정말 많은 영상 특징을 뽑았고, 그걸 조합해서 예측에 사용했다. 두 연구의 방법론적 차이는 특징을 어떻게 디자인했냐이다. 특징을 미리 알려진 특징을 뽑았는지 아니면 그 과정을 일부 비지도 학습 방법을 사용하였는가이다. 물론 그렇게 선택된 많은 특징들을 두 논문 다 특징 선택 (feature selection) 과정을 거치게 되어 있다. 이런 과정들이 있는데 이번 논문이 뭐든 스스로 된 다는 애매모호한 말로 포장하면 이는 사기이다. 오히려 정말 자동화된 연구가 들어올 자리를 미리 없애는 행위일 수 있다. 또한, 설명 가능한 (explainable) 지식이라고 표현 했지만 위에서 언급한 대로 특징을 뽑아서 의사 선생님들이 다시 리뷰를 해 봤더니 이러저러한 특징도 뽑혔다고 인지할 수 있다는 의미에 더 가깝다.

이런 경우에는 오히려 해석 가능한 (interpretable)이란 용어가 더 어울린다. 설명 가능하다기보다는 일부 특징이 일부 전문의들이 아는 정보와 맞닿아 있어 해석이 가능한 경우가 있었다고 표현하는 것이 맞다. 해석이 가능하다고 설명 가능하진 않다.

또한, 이 논문의 실험은 GS라는, 기존에 암의 진행 정도를 나타내는 아주 오래된 기준에 비하여 자동화되어 뽑힌 100여개의 특징을 이용하면 나은 정확도를 보여주었다. 즉, 이미지를 아주 단순한 1차원 수로 줄인 특징 하나와 애써 뽑은 100여개의 수치와 비교했을때에 100여개가 낫다는 결과이다. 그것도 GS는 1년 후 예후 예측을 위해 설계되거나 구축된 수치도 아니다. 당장 수술해야 하는 위험한 암이라도 그 암이 1년 후 재발이 잘 되는 거인지 아닌지의 기술로 평가하진 않으니깐 기준 자체가 다른 수치이다. 기준을 제대로 읽어보면 이 등급을 특징으로써 정량화된 값으로 쓰기엔 무리가 있다는 걸 알 수 있다. 그러니 이 프레임을 씌워서 의사가 보다 잘 한다는 언론의 홍보 기사는 연구의 요지를 곡해한 것이다. 가끔 주제넘게 외부에서 AI 적용에 대해 세미나를 할 때면 “AI를 적용하려면 AI를 없애야 한다"라고 주장한다. 공상 소설에서 등장하여 쓰게 된 AI란 용어만큼 그 정의가 애매모호한 경우도 없다. 그러나 의료와 같은 실제 분야에 적용하기 위해서는 이 애매함을 지우는 것이 중요하다.

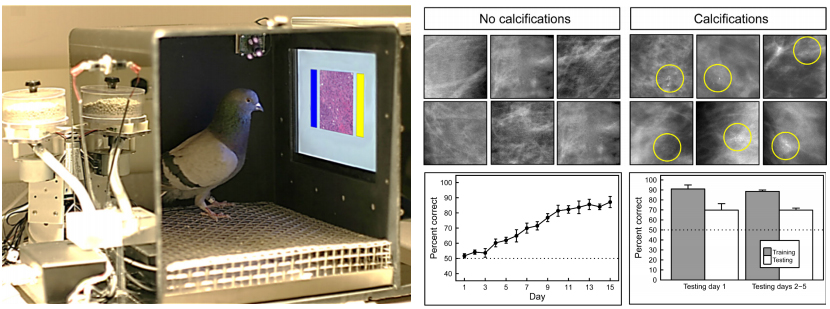

그림. 1. 비둘기가 학습을 통하여 약 90%의 정확도로 유암방을 감별한다고 보고 [11].

현실성 없음에 눈 감는 방관자가 아니라 참여자가 되어야 한다.

앞에서 몇 의료 AI 연구와 언론에서 그 연구들이 어떻게 소개되었는지 살펴보았다. 좋은 연구를 했지만 현실을 반영하지 못하여 쓰이지 못하기도 하고, 현실을 제대로 알지 못하는 언론과 현실보다는 홍보가 목적인 기사들을 통해 연구의 의도에서 벗어난 오해를 불러일으키기도 했다. 그러나 의료 AI는 분명 지난 몇 년간 엄청나게 발전하였고, 의료의 발전을 위해서는 함께 가야 한다. 현실성 없게 정신없이 바쁜병원에서 연애나 하는 얘기가 나온다고 의학 드라마를 보지 않기보다는 제대로 된 시선과 기준으로 현실을 반영하고 제대로 된 인식과 메시지를 전달할수 있는 의학 드라마가 나올 수 있게 전문가들이 나서줘야 한다. 그렇지 않으면 한국 의료 AI 분야에는 절대 임상에 사용될 수 없는 이쁜 쓰레기들이 넘쳐날 것이고 그런 것들을 이용한 사기꾼이 국가 예산과 투자금을 눈먼 돈처럼 사라지게 할 것이다.

간혹 제한된 데이터에서 검증되지 않은 높은 정확도란 수치를 내세우며 기술 변화가 빠른 분야이니 다른 기준이 적용되어야 한다거나 스타트업이나 기업을 살리기 위해 의학계에서 오랫동안 기준이 되는 임상 절차와 그 프로세스가 과하다고 말하는 정치가와 기업가들이 있다. 비둘기도 학습을 통하면 유방암 감별에 약 90%라는 높은 수치를 나타냈었다 [11]. 그 논리대로라면 우리는 비둘기에게도 문을 활짝 열어야 한다. 새로운 기술에 대해 열린 자세로 협력하는 것과 전문가들이 오랫동안 만들어온 기준을 무너트리는 것과는 다른 얘기이다. 그래서 더욱더 의료계에서는 의료 AI 분야에 방관자가 아니라 참여자가 되어야 한다. 어설프게 AI를 배우라는 얘기가 아니라 자신의 분야에 더 전문성을 발휘하고 제대로 된 기준과 프로세스를 의료 AI에 요구하여야 한다. 적당히 논문이나 과제, 그리고 투자금이나 바라는 연구와 회사들에 의해 기준과 프로세스가 무너지지 않게 하고 오해가 생기지 않게 해 주어야 한다. 그러면서도 새로운 기술이 제대로 된 방식으로 의료계에 들어올 수 있도록 지도하고 관리해 주고 그 바탕이 되는 데이터들이 제대로 쌓이게 해 주어야 한다. 그렇지 않으면 시청률만 잘 나오면 그만인 현실성 없는 의학 드라마가 판을 치듯, 의료 현실이 무엇이든 한국 의료 AI계가 어떻게 되든 투자 많이 받아 기업공개나 하고 매각이 목표인 의료 AI 업체들이 판을 칠 것이다. 그리고 그들이 돈만 들고 떠난 후 의료계에는 쓸 수 없는 이쁜 쓰레기만 넘쳐날 수도 있다. 그리고 그런 의료계에 남아서 문제를 계속 해결하셔야 하는 분들은 묵묵히 계속 사람을 살린 죄밖에 없는 의료인들이다.

[1]

Varun Gulshan, Lily Peng, Marc Coram, et al, “Development and Validation of a Deep Learning Algorithm for Detection of Diabetic Retinopathy in Retinal Fundus Photographs,” JAMA. 2016, 316(22), 2402-2410. doi:10.1001/jama.2016.17216

[2] Poplin, R., Varadarajan, A.V., Blumer, K. et al. “Prediction of cardiovascular risk factors from retinal fundus photographs via deep learning,” Nat. Biomed. Eng. 20182, 158–164. https://doi.org/10.1038/ s41551-018-0195-0

[3] https://www.theverge.com/2018/2/19/17 027902/google-verily-ai-algorithm-eye-scan-heart-disease-cardiovascular-risk

[4] Hollon, T.C., Pandian, B., Adapa, A.R. et al. Near real-time intraoperative brain tumor diagnosis using stimulated Raman histology and deep neural networks. Nat Med 26, 52–58 (2020). https://doi.org/10.1038/ s41591-019-0715-9

[5] https://biz.chosun.com/site/data/html_dir/2020/01/07/2020010700001.html?utm_source=naver&utm_medium=original&utm_campaign=biz&fbclid=IwAR2EeNi2bUf4AuMOV7paaB8noknjghFdduza6pZEDj1iu 9T7BjBWoRoSoGI

[6] Orringer, D., Pandian, B., Niknafs, Y. et al. Rapid intraoperative histology of unprocessed surgical specimens via fibre-laserbased stimulated Raman scattering microscopy. Nat Biomed Eng 1, 0027 (2017). https://doi.org/10.1038/s41551-016-0027

[7] Park, J., Park, C., Yu, H. et al. Subwavelength light focusing using random nanoparticles. Nature Photon 7, 454–458 (2013).https://doi.org/10.1038/nphoton.2013.95

[8] Yamamoto, Y., Tsuzuki, T., Akatsuka, J. et al. Automated acquisition of explainable knowledge from unannotated histopathology images. Nat Commun 10, 5642 (2019). https://doi.org/10.1038/ s41467-019-13647-8

[9] http://medipana.com/news/news_viewer.asp?NewsNum=251137&MainKind=A&NewsKind=5&vCount=12&vKind=1&fbclid=IwAR2pfUPpN-G-D9ELti_yr7wVelz8Mu57cP6YlSwDbmqBF6kHaBqx6x M9BTY

[10] Yu, K., Zhang, C., Berry, G. et al. Predicting non-small cell lung cancer prognosis by fully automated microscopic pathologyimage features. Nat Commun 7, 12474 (2016). https://doi.org/10.1038/ncomms12474

[11] Richard M. Levenson, Elizabeth A. Krupinski, Victor M. Navarro, et al. Pigeons (Columba livia) as Trainable Observers of